Er du også lige startet på A/B split-test, men er lidt usikker på mulighederne eller i tvivl om hvordan du kommer videre, ja så kan du sikkert også få glæde af denne gennemgang af spørgsmål/svar om split-test i Visual Website Optimizer (VWO).

I dag havde jeg et skypemøde med en ejer af en webshop. De sælger tilbehør til mobiltelefoner og den slags. Jeg havde lovet at give et par gode råd til split-test i Visual Website optimizer. Spørgsmålene og svarene er ret typiske for den type spørgsmål og den type svar jeg får og giver, til personer der er nye indenfor split-test. Derfor deler jeg dem med dig, så kan det være du også kan få glæde af dem. Det er lidt langt (og lige fra hoften, så ikke så meget korrektur og fikumdik), så spring eventuelt til det spørgsmål der kunne have din interesse.

Jeg har ikke optaget samtalen, så min gengivelse er udfra hukommelsen fra i eftermiddags:

Spørgsmål 1

Jeg vil gerne split-teste farven på købsknappen på min produktside, så jeg har tænkt mig at kopiere hele websitet og så lave en version med den originale farve og en kopi af alle produktsiderne med den anden farve - og så bruge en split-URL test til at finde ud af hvilken der fungerer bedst.

Svar 1

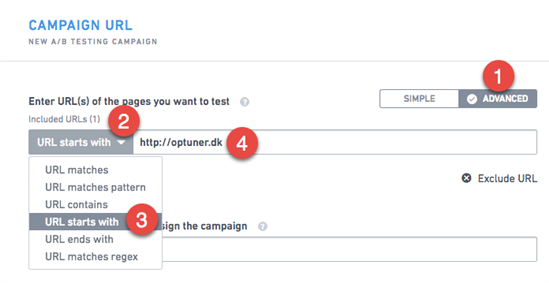

I det spørgsmål sætter du gang i en række aspekter, som jeg er nødt til at afklare og forklare først. Forstår jeg rigtigt at du vil teste en ny knapfarve, ikke blot på 1 enkelt produktside, men på alle produktsider samtidigt i samme test? (ja). Så er den løsning du beskriver ikke den bedste, tværtimod (slevom man godt kan). Du kan i stedet, relativt let, ændre knappen på 1 enkelt side, ved at fortælle editoren i VWO at det er netop det html-element du ønsker at ændre, men så tilføje at VWO skal foretage den ændring hver gang den møder det element på hele websitet. Altså det der kaldes "site-wide". Så du sætter testen op som du plejer, men bagefter skal du give VWO den URL - eller det URL-mønster - som VWO skal genkende for at køre testen på en given side. Skriver du fx www.oleg.dk/, så skifter VWO det element ud på alle underliggende sider på hele sitet. Ergo får din test altså meget mere trafik og kan derved opnå et troværdigt resultat, end hvis du kun køre testen på en enkelt produktside.

Billedtekst: 1) Ved Campaign URL vælger først Advanced, 2) Vælg dropdown ved URL Matches 3) Vælg URL starts with, 4) Her kører testen fx på alle sider under Optuner.dk

At kopiere sitet og bruge split-test er ikke en god løsning af rigtigt mange årsager - og så er split-url i VWO ikke altid velfungerende, det kan "hakke" lidt når den nye URL skal indlæses.

Så er du også nødt til at overveje om det er relevant at teste farven på købsknappen, om det virkeligt er det værd. Er valget af den test baseret på nogen form for indsigt eller hypotese - kan det med andre ord kvalificeres, eller er det bare fordi det siger nogen er cool? Som konsulent vil jeg altid anbefale at få lavet en form for analyse, fx af Google Analytics data, en Optuner brugertest eller en ekspertgennemgang, for at kvalificere hvor der i virkeligheden er problemer og så teste variationer på det. Som minimum bør du mere systematisk undersøge, hvilke erfaringer der er med split-test af produktsider ude i verden og så overveje at afprøve de mest succesfulde. Men husk at deres resultater ikke garanterer resultater for dig. Og bliv ikke skuffet hvis du oplever, at det ikke har den store betydning af skifte farve på knappen.

Spørgsmål 2

Jo, men jeg har kørt en split-test på et Trustpilot-element på produktsiden og det gav et godt resultat. Jeg havde 200 besøg på hver kontrol og variant, og varianten (med Trustpilot) vandt med 22 salg mod 15 salg.

Svar 2

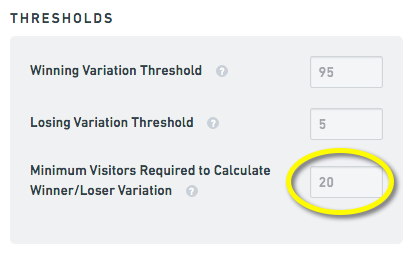

Lad mig starte med at sige at jeg - og jeg tror de fleste af mine konsulent-kolleger i branchen vil være enige - mener at det er alt alt for lidt trafik til at sige noget-som-helst troværdigt om hvad der fungerer bedst. Det kan godt være at VWO efter kort tid fortæller at den ene version er en vinder, men usikkerheden på det resultat er simpelthen statistisk vildt stor. Resultatet er at du skyder dig selv i foden og implementerer noget der ikke har nogen reel effekt, ja eller som ligefrem skader din konvertering. Bare tænkt på det sådan her: Den test er kørt på al din trafik, men den trafik er blandet af betalt trafik, organisk trafik, måske mobil trafik, osv. Altså trafik der kommer fra vidt forskellige kilder, med brugere der er blevet motiveret til at gå til din webshop på vidt forskellige måder. Hvis du bare deler det op i fx 50% betalt trafik og 50% organisk, så forskellen på kontrol og variant været fra 8 til 11. Der skal kun ganske få klik til at resultatet havde været omvendt. Altså slet ikke troværdigt. Samtidigt har testen sikkert kun kørt i kort tid (svaret var 2 dage), så du har måske slet ikke været forbi fx en weekend, hvor brugerne angiveligt har bedre tid og måske agerer anderledes. Så test med så små tal og med så kort et forløb er simpelthen fuld af fejlkilder. Vi plejer at sige mindst 200 konverteringer pr. variation, nogle siger 300. Nogle konsulenter siger at testen bør køre i 3 uger mindst. Og det også selvom VWO har introduceret Bayesiske beregninger, der angiveligt er bedre til at håndtere små mængder trafik.

Billedtekst: Som standard kræver VWO kun 20 besøg pr. variation for at ville erklære en vinder. Det er ik' møj.

Spørgsmål 3

Jamen kan jeg så ikke køre flere split-test samtidigt, så jeg ikke er hæmmet af kun at kunne køre så få test.

Svar 3

Generelt vil jeg fraråde at køre flere test samtidigt, især hvis en given bruger kan komme til at indgå i flere test i samme besøg. Deter der flere grunde til. For det første er det vigtigt i en split-test af kunne isolere årsag-effekt. Altså at være sikker på at den ændring man foretager også er direkte relateret til det resultat man kan aflæse. Hvis man laver flere ændringer på samme tid, hvilken ændring var det så der gav mest effekt? Kan den ændring man lavede reelt tilskrives den øgede konvertering? Det er vigtigt, ellers snyder man igen sig selv. Laver man flere ændringer samtidigt, så er der nærmest tale om en multi-variant-test og det åbner for helt andre udfordringer. Teoretisk set kunne man sikre sig at brugerne deles op, sådan at gruppe 1 ser test 1 og gruppe 2 ser test 2. Men igen, så halverer man sin trafik og den er der ofte allerede for lidt af i mange test. Derudover er jeg på stående fod, usikker på om man på den måde kan styre det så præcist i VWO.

Det andre problem opstår hvis man fx kører to test forskellige steder på websitet samtidigt. Her skal man være opmærksom på at fx ændringer på forsiden, forplanter sig på hele brugerrejsen frem til den endelige konvertering. Det kan være at man sætter brugeren i et særligt "frame-of-mind", eller at man lover brugeren en gevinst, som bliver styrende for hvordan de agerer indtil købet er afsluttet (det man kalder for priming). Hvis man laver en test på forsiden og måler på konverteringer hele vejen ned gennem købstragten, så vil man se at konverteringsraterne ikke kun ændrer sig fra forsiden og så til næste trin. Det ændrer sig hele vejen, hvilket også er derfor at man reelt skal måle på alle trinene og se på den samlede største konvertering.

Hvad gør man så. Ja, det korte onde svar er at man vælger sine split-test med omhu, tester på store ting der giver store læringer (bemærk at jeg bevidst skriver læringer, fordi store taber-test også giver læring) og kører dem færdige, så man er helt sikkert på sit statistiske resultat. Ellers viser erfaringen, at man aldrig får det løft man blev lovet i den fine statistik i VWO.

Spørgsmål 4

Jeg vil gerne teste en "ned-tæller" på produktsiden der tæller ned omkring levering til næste dag. Hvordan gør jeg så det med split-test, når det nu ikke er en god idé at lave som split-URL test?

Svar 4

Generelt er der to måder at gøre det på. Enten kan du konstruere en produktside med den tæller på og så lave en variation, hvor du fjerne tælleren. Så sætter du det site-wide. Grunden til den tilgang er at det er nemt at identificere elementet (tælleren) og klikke "hide" i editoren. Den mere korrekte tilgang (i relation til navngivningen af kontrol og variation) er at du på variationen, vælger VWO's scripteditor og indsætter det javascript der genererer tælleren. Igen kører du det site-wide. Det svære her er sådan set kun at indsætte kode, i stedet for at klikke på et element i editoren og rette det. Men det er nemt at lære. Hvis du ikke selv laver koden, så kan din udvikler eller dit bureau sende dig den stump javascript og så kan du selv indsætte den.

VWO kan mange sexede ting der, fx har jeg kørt en test hvor vi udskiftede et dynamisk mængderabat-element, sådan at der i variationen også blev indsat dynamiske tal, men i et helt andet design. Til gengæld skulle det kun ske på sider hvor der var mængderabat, ikke på alle sider og det var ikke noget der kunne adskilles på URL. På alle produktsider hvor der var mængderabat, blev der indsat en kode, der fortalte VWO at her skulle testen indgå. På de sider var der i koden 2 versioner af mængderabat-elementet, og så lod vi VWO styre hvilken version der skulle vises. Og hopla - split-test af dynamisk mængderabat-element på udvalgte sider på hele sitet. Med de muligheder, kan man stort set teste hvad-som-helst, så længe man har en god udvikler ved sin side :-)

Spørgsmål 5

Jeg vil gerne afprøve nogle helt re-designede kategorisider, hvor jeg laver helt om på designet og så køre det på alle kategorisider på hele sitet. Skal jeg så gøre det med A/B split-test?

Svar 5

Det kan være svært at svare entydigt på, for det kommer helt an på hvilke og hvor mange ændringer du foretager. Er det kun i stylesheetet eller er det også helt ny HTML og dynamisk indhold? Hvis det generelt er hele siden, så begynder det at lugte af split-URL, fordi VWO ellers skal ændre på så mange elementer samtidigt. Men det bedste man kan gøre er at designe den side og tage bestik af det. Hvis man kan foretage alle de ændringer i VWO's editor, så kan man reelt køre testen som A/B split-test, men hvis man skal ud og hente udvikleren og bygge siden op på ny, så kan det være at split-URL testen er bedre - ikke mindst fordi det så bliver langt nemmere. Ellers skal man jo efterfølgende ind i editoren og prøve at genskabe den nye side. Det virker bøvlet. Udfordringen med Split-URL testen er så at køre den sitewide. Split-URL testen er jo lavet til at sende brugere til en bestemt URL, videre til en anden URL, ikke til at skifte elementer ud på en side. Så enten vil det kræve en split-URL test til hver kategoriside, eller du skal lave en generisk kategoriside og så sende en parameter med, der styrer hvilken kategori der indlæses i siden. Nu er vi så over i noget lidt mere avanceret. Men værktøjerne er vildt fleksible, så det primære er at vide hvad man vil og så derefter finde den bedst mulige måde at eksekvere det i fx VWO.

Spørgsmål 6

Når jeg kigger på previewet i VWO så kan jeg ikke se ændringen - hvordan kan det være?

Svar 6

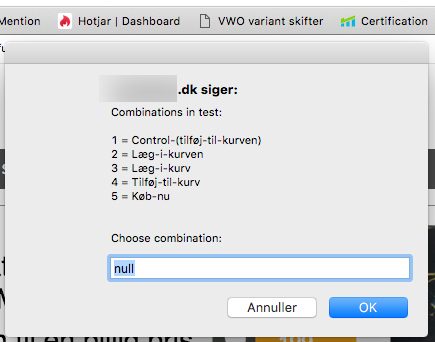

Det er jo noget VWO support kan svare meget bedre på, men jeg vil sige, at det også ofte sker for mig. Så jeg har en række vaner med at afprøve det på andre måder. Problemet opstår enten fordi testen ikke er aktiv, eller fordi man ser på en side der ikke indgår i testen - ja, eller at der er noget galt. Jeg bruger ofte Chrome's incognito session og refresher indtil jeg føler mig sikker på om det virker eller ej (jeg medgiver at det er meget manuelt). Der findes også et plugin til Chrome, hvor man kan trigge forskellige variationer af test på en side (også på "fremmede" sider ;-)). Endeligt bør man altid koble sin test til Google Analytics og der vil man også kunne se om data flyder korrekt ind. Men igen, manglende preview er altid en alarmklokke, så det skal man tage seriøst.

Billedtekst: "Spion"-pluing i Chrone, viser både om der køres en test, hvad variationerne hedder og tillader at man kan vælge de forskellige variationer.

Det var det. Har du (læseren) kommentarer eller forslag eller erfaringer der kan supplere ovenstående, så skriv endeligt. Håber noget af ovenstående kan hjælpe andre til at komme i gang med split-test.

God fornøjelse,

Ole G.

Bliv gratis medlem

Bliv gratis medlem